Neste post, falaremos sobre o coeficiente kappa de Cohen, uma medida útil para avaliar a concordância entre avaliadores. Primeiramente, descreveremos algumas perguntas de pesquisa que podem ser respondidas usando o kappa de Cohen. Em seguida, apresentaremos duas medidas de concordância entre avaliadores. Por fim, apresentaremos um tutorial no SPSS de como solicitar, interpretar e reportar o kappa de Cohen.

Perguntas de pesquisa que envolvem medidas de concordância

Considere os três cenários a seguir. Primeiramente, duas psicólogas clínicas assistem aos vídeos de uma terceira psicóloga entrevistando adolescentes. Com base nesses vídeos, as duas primeiras psicólogas devem classificar cada adolescente em uma de três categorias: (1) sem problemas de comportamento; (2) com problemas internalizantes de comportamento (e.g., retraídos); e (3) com problemas externalizantes de comportamento (e.g., agressivos).

No segundo cenário, após aplicarem uma tarefa de nomeação de objetos a uma paciente que sofreu um acidente vascular cerebral, duas fonoaudiólogas categorizam cada verbalização da paciente em uma de quatro categorias, a saber, acerto (e.g., nomear dedo de dedo), erro semântico (e.g., nomear dedo de mão), erro fonológico (e.g., nomear dedo de tedo) e omissão (e.g., não emitir resposta).

Por fim, dois membros de uma equipe de pesquisa ficaram responsáveis por codificar os estudos que serão incluídos em uma revisão metanalítica. Por exemplo, eles precisam ler as seções de Método dos artigos e extrair informações relevantes, como modalidade sensorial dos estímulos (e.g., visual, auditiva, tátil), duração da tarefa (e.g., até 30 min, mais de 30 min) e tipo de amostra (e.g., neurotípica, neurodivergente). Tal codificação será relevante, pois essas características dos estudos serão usadas como potenciais variáveis moderadoras na revisão metanalítica.

Qual é o elemento comum aos três cenários anteriores? Em síntese, os personagens de nossos exemplos atuam como juízes, observadores ou avaliadores que visam mensurar algum atributo da realidade de maneira fidedigna. Idealmente, em todos os cenários, os avaliadores chegariam a classificações idênticas em cada atributo.

Na prática, contudo, avaliadores são imperfeitos e podem discordar em alguns casos. No entanto, assim como gostaríamos de conhecer as propriedades psicométricas de nossos instrumentos, também queremos ter evidências de que nossos avaliadores apresentam boa concordância, antes de seguirmos com as demais análises em nossa pesquisa.

Medidas de concordância entre avaliadores

Porcentagem de concordância

A fim de explorarmos as medidas de concordância, vamos abordar em mais detalhes nosso primeiro exemplo da seção anterior. Suponha que as psicólogas clínicas tenham classificado 30 adolescentes como estando sem problemas de comportamento, com problemas internalizantes ou com problemas externalizantes.

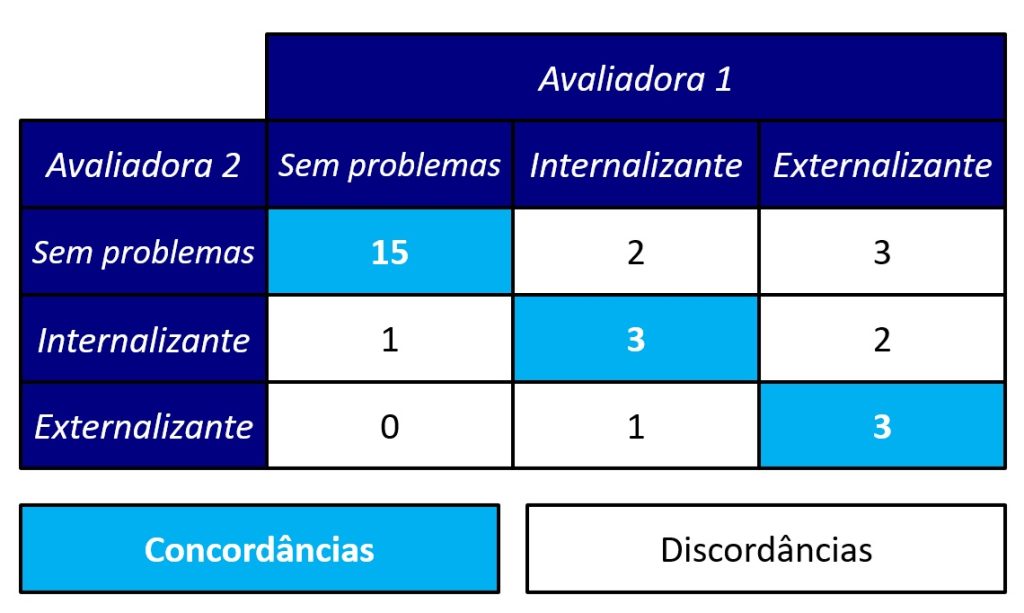

A Figura 1 apresenta dados hipotéticos desse estudo. Ela representa uma tabela de contingências 3 × 3, onde cruzamos as frequências de categorizações das avaliadoras às diferentes categorias. De forma genérica, construíremos uma tabela de contingências m × m, onde m é o número de categorias existentes no esquema de classificação.

Na Figura 1, destacamos os elementos da diagonal principal, pois eles correspondem às instâncias de concordância entre as duas avaliadoras.

Sendo assim, uma medida que poderíamos usar para avaliar a concordância entre avaliadoras é o percentual de concordância, que corresponde à soma dos elementos da diagonal principal dividida pela soma total da tabela. Em nosso exemplo, temos:

Em síntese, as psicólogas clínicas concordaram na classificação de 70% dos adolescentes da amostra.

Kappa de Cohen

No entanto, o percentual de concordância possui uma importante limitação: ele desconsidera o fato de que avaliadores podem concordar apenas devido ao acaso.

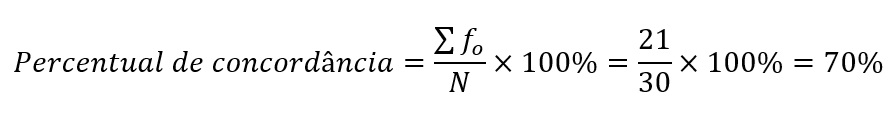

Por exemplo, considere o cenário em que as avaliadoras nada entendem sobre problemas comportamentais em adolescentes. Coincidentemente, ambas decidem adotar uma estratégia de classificação baseada na sorte: elas lançam um dado para cima e classificam cada adolescente em uma determinada categoria, conforme o esquema da Figura 2.

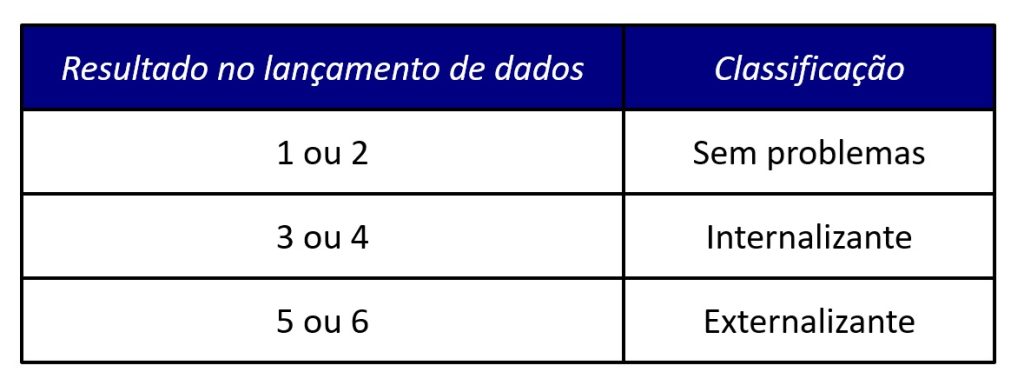

Cohen (1960) propôs o kappa (κ) de Cohen, uma medida de concordância corrigida para concordâncias ao acaso. Para usá-la, procedemos inicialmente de modo similar ao teste qui-quadrado de independência, onde calculamos as frequências esperadas da tabela de contingências (para os cálculos, veja nosso post sobre o teste qui-quadrado de independência). A tabela de contingências 3 × 3 com frequências esperadas é apresentada na Figura 3.

Finalmente, a fórmula do kappa de Cohen é dada por:

onde Σfo representa a soma das frequências observadas na diagonal principal da Figura 1 (i.e., as concordâncias empíricas), Σfe representa a soma das frequências esperadas na diagonal principal da Figura 3 (i.e., as concordâncias esperadas apenas devido ao acaso) e N representa a soma das frequências da tabela da Figura 1 (i.e., o máximo de concordâncias possível).

Dada a definição do kappa de Cohen, seu valor variará entre 0 e 1, sendo que o valor 1 ocorrerá quando Σfo = N. Em nosso exemplo, temos:

Portanto, o kappa de Cohen, sendo uma medida corrigida para concordâncias ao acaso, indica que as concordâncias foram relativamente baixas (47%) entre as duas psicólogas clínicas.

Uma observação sobre o kappa de Cohen

É importante observamos que o kappa de Cohen é aplicável quando almejamos estimar a concordância entre dois avaliadores. No entanto, quando temos mais de dois avaliadores, é preciso adotar outras medidas para esse fim.

Por exemplo, uma generalização do kappa de Cohen para três ou mais avaliadores é conhecida como kappa de Fleiss. Também temos um post sobre essa medida aqui no blog.

Como calcular o kappa de Cohen no SPSS?

O banco de dados

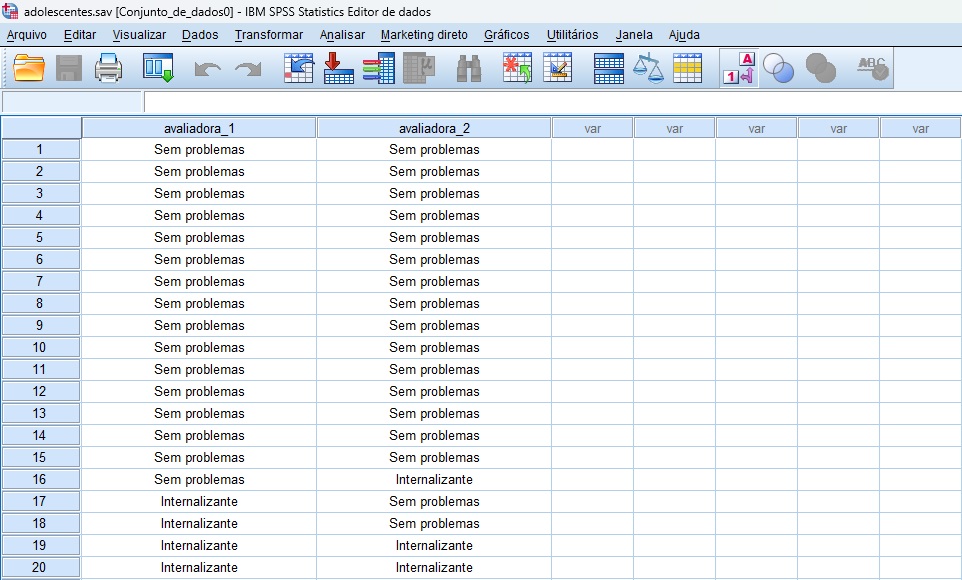

A Figura 4 apresenta o banco de dados para o tutorial. Ele possui duas colunas, cada uma delas codificando as classificações de uma das avaliadoras. As linhas representam os diferentes adolescentes do exemplo de problemas comportamentais.

Embora as informações no banco de dados da Figura 4 pareçam textuais, nós codificamos valores numéricos para cada uma das categorias, para fins de análise de dados. Isso é necessário, para conseguirmos solicitar o kappa de Cohen.

Se seus avaliadores estiverem codificando diferentes atributos (e.g., diferentes variáveis para uma revisão metanalítica), então você precisará ter múltiplos pares de coluna, um par para cada atributo. Nesse caso, portanto, você computará um kappa de Cohen para cada atributo sob avaliação.

Solicitando o kappa de Cohen

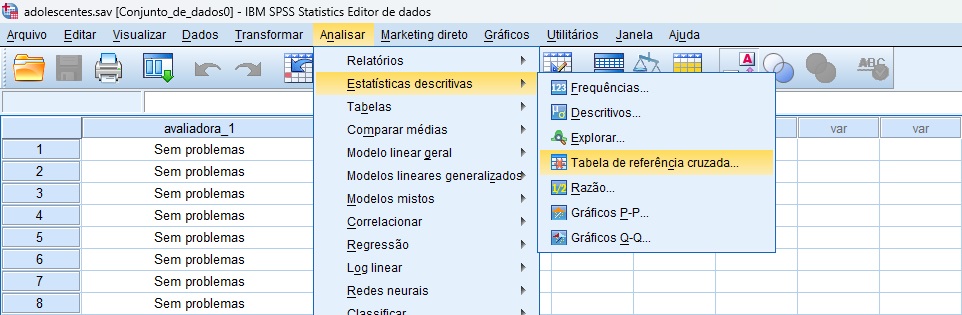

Primeiramente, siga o caminho Analisar > Estatísticas descritivas > Tabela de referência cruzada (Figura 5).

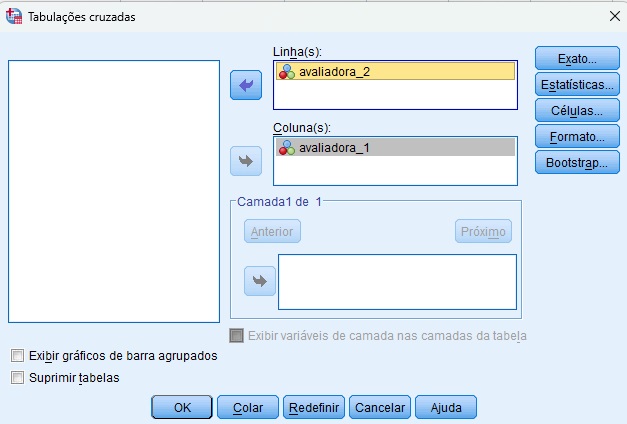

Em seguida, transfira uma das variáveis para o quadro de Linha(s) e a outra, para o quadro de Coluna(s), tal como ilustramos na Figura 6. A ordem de inserção das variáveis não terá impacto nos resultados.

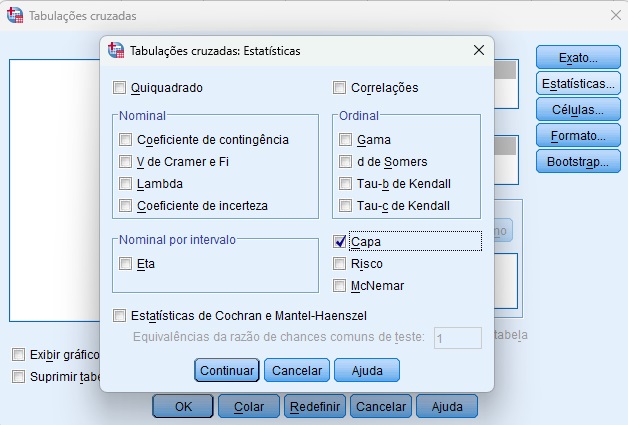

Clique no botão Estatísticas. Isso abrirá uma nova janela, onde você marcará a opção Capa (kappa de Cohen). Por fim, clique em Continuar, e depois, em OK (Figura 7).

Interpretando as saídas

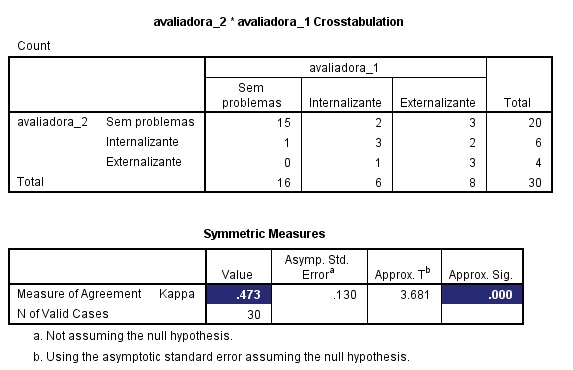

A Figura 8 apresenta as principais saídas da análise. Primeiramente, temos a tabela de contingências 3 × 3 das frequências observadas, que é similar àquela da Figura 1.

Mais importante, a tabela Symmetric Measures apresenta o valor do kappa de Cohen, que foi similar ao que calculamos anteriormente de forma manual. Além disso, o SPSS apresenta o valor de p (Approx. Sig.), que indica se o valor foi estatisticamente diferente de zero.

Como mostra a Figura 8, o valor do kappa foi significativo. No entanto, em análises de concordância, geralmente não é suficiente o valor ser estatisticamente diferente de zero. Desejamos, nesse caso, que o valor seja o mais elevado possível. Em seguida, veremos como interpretar o valor absoluto do kappa.

Como reportar o kappa de Cohen?

Teoricamente, o valor máximo de kappa de Cohen será 1 quando ambos os avaliadores concordarem em todas as instâncias avaliadas (i.e., quando a tabela de contingências tiver valores apenas na diagonal principal). McHugh (2012) fornece orientações para interpretação do valor do kappa de Cohen, conforme nossa reprodução na Tabela 1.

| Valor do kappa | Nível de concordância | Porcentagem de dados que são confiáveis |

| 0 a 0,20 | Nenhum | 0 a 4 |

| 0,21 a 0,39 | Mínimo | 4 a 15 |

| 0,40 a 0,59 | Fraco | 15 a 35 |

| 0,60 a 0,79 | Moderado | 35 a 63 |

| 0,80 a 0,90 | Forte | 64 a 81 |

| Acima de 0,90 | Quase perfeito | 82 a 100 |

Desse modo, apresentamos uma sugestão de relato dos resultados no parágrafo a seguir:

Com base em vídeos de entrevistas de adolescentes, duas psicólogas clínicas, de forma independente, classificaram os adolescentes em uma de três categorias, a saber, sem problemas de comportamento, com problemas de comportamento internalizantes e com problemas de comportamento externalizantes. A medida de concordância corrigida pelo acaso indicou que as psicólogas concordaram significativamente acima de 0, κ = 0,47, p < 0,001. No entanto, o índice de concordância foi fraco (McHugh, 2012).

Contudo, na prática, uma concordância tão baixa pode indicar um treinamento pobre dos avaliadores, falta de expertise ou mesmo não comprometimento com a tarefa de classificação. Ou seja, dificilmente as inferências oriundas de tais classificações serão confiáveis.

Sendo assim, tais casos podem exigir que novos avaliadores sejam treinados, ou que o protocolo de instruções para a classificação seja mais bem detalhado, de modo a realizar novamente a etapa de classificação, visando produzir medidas com índices acima de 0,80.

Conclusão

Neste post, descrevemos o kappa de Cohen e seu uso a fim de estimar a concordância entre avaliadores. Desse modo, o kappa permite responder a diferentes questões de pesquisa. Além disso, apresentamos um tutorial no SPSS de como solicitar, interprertar e reportar o kappa de Cohen em seus estudos.

Se você precisa aprender análise de dados, então faça parte da Psicometria Online Academy, a maior formação de pesquisadores quantitativos da América Latina. Conheça toda nossa estrutura aqui e nunca mais passe trabalho sozinho(a).

Referências

Cohen, J. A. (1960). Coefficient of agreement for nominal scales. Journal of Educational and Measurement, 20(1), 37–46. https://doi.org/10.1177/001316446002000104

Howell, D. C. (2013). Categorical data and chi-square. In D. C. Howell, Statistical methods for psychology (8th ed., pp. 137–176). Wadsworth Cengage Learning.

McHugh, M. L. (2012). Interrater reliability: The kappa statistic. Biochemia Medica, 22(3), 276–282.

Como citar este post

Lima, M. (2025, 23 de janeiro). O que é o coeficiente kappa de Cohen? Blog Psicometria Online. https://www.blog.psicometriaonline.com.br/kappa-de-cohen/